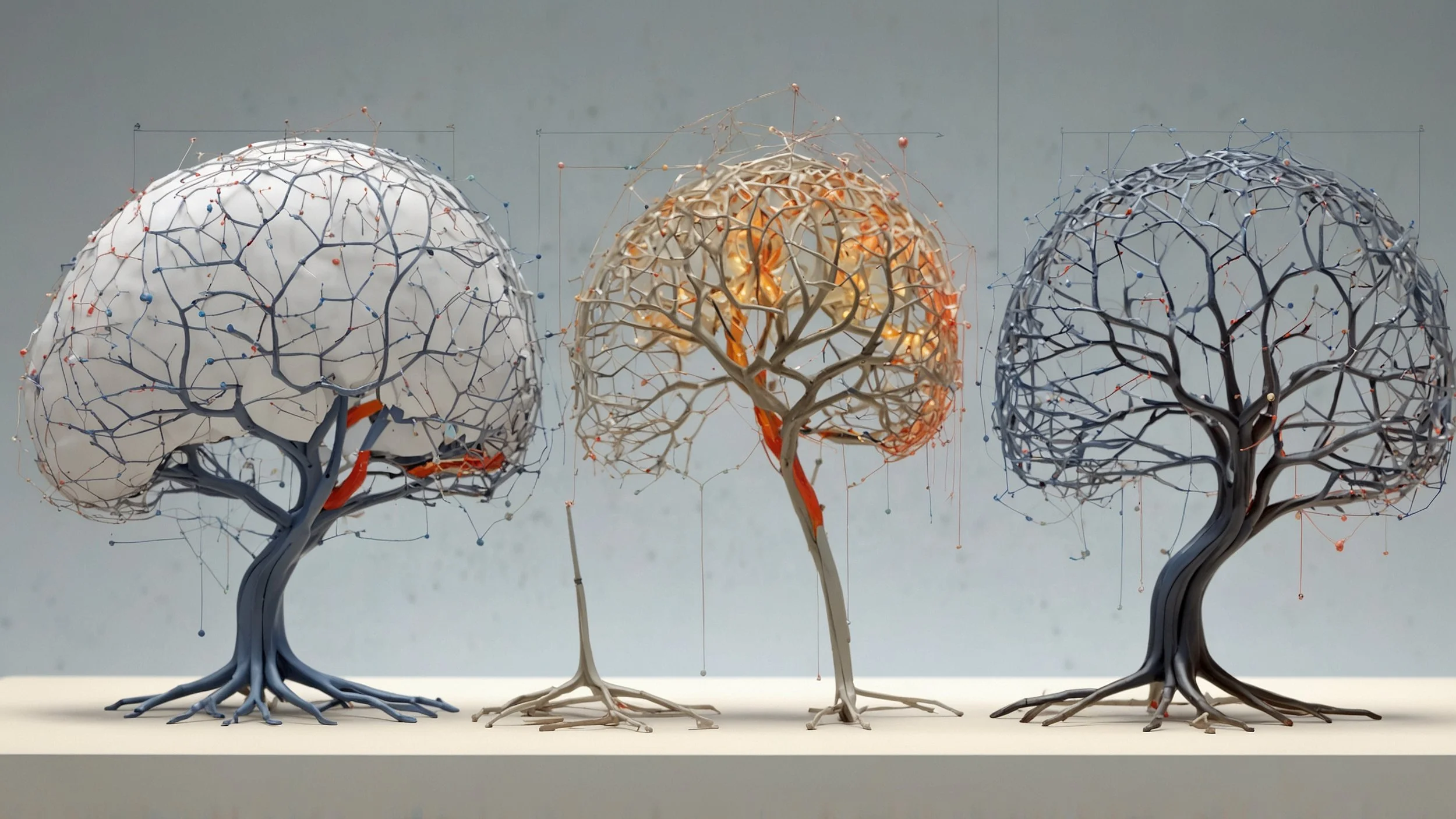

La inteligencia artificial explicable: clave para la transparencia y la confianza

Conforme la inteligencia artificial (IA) progresa, su función en áreas como la salud, las finanzas y la seguridad informática se vuelve esencial. No obstante, el problema de la caja negra ha suscitado inquietudes éticas al complicar el entendimiento de cómo se realizan las decisiones. Es en este punto donde la Inteligencia Artificial Explicable (XAI) se presenta, intentando hacer estas tecnologías más accesibles y entendibles, asegurando de esta manera un uso ético y responsable.

La necesidad de la transparencia en la inteligencia artificial

La Inteligencia Artificial explicable intenta solucionar la inherente ausencia de transparencia en los sistemas de IA complejos. Este método brinda a los usuarios la posibilidad de no solo observar, sino comprender, las causas de las decisiones producidas por los **algoritmos de aprendizaje automático. Especialmente en áreas vitales, como la asistencia sanitaria y financiera, esta transparencia posibilita que los expertos confíen en las sugerencias y los resultados obtenidos, reforzando el vínculo entre humanos y maquinaria y garantizando decisiones equitativas y basadas en evidencia.

Técnicas para lograr la explicabilidad en inteligencia artificial

En el ámbito de la inteligencia artificial y el aprendizaje automático, la explicabilidad de los modelos es crucial para garantizar la confianza y comprensión de sus decisiones. Existen dos estrategias fundamentales para lograr esta explicabilidad:

Enfoque Intrínseco: Emplea modelos interpretables. Ejemplos incluyen árboles de decisión, que presentan rutas de decisión claras y fáciles de seguir, y regresiones lineales, donde las relaciones entre variables son explícitas.

Métodos Posthoc: Se aplican a modelos complejos ya entrenados. Utilizan herramientas como análisis de relevancia de rasgos, que evalúan qué características influyen más en las decisiones.

Explicaciones Contrafactuales: Permiten comprender el modelo al responder a “qué pasaría si”. Clarifican cómo ciertos cambios en los rasgos podrían alterar la decisión del sistema.

Importancia de la Explicabilidad: Facilita la confianza del usuario. Permite a los desarrolladores y stakeholders entender por qué un modelo toma ciertas decisiones en lugar de otras.

Aplicaciones Prácticas: Útiles en sectores críticos como salud y finanzas. Determinan el impacto de ciertos parámetros y garantizan decisiones justas y transparentes.

Los retos y el futuro de la inteligencia artificial explicable

A pesar de que la Inteligencia Artificial Explicable (XAI, por sus siglas en inglés) tiene un gran potencial, enfrenta retos significativos:

Equilibrio entre exactitud y comprensión: Los modelos altamente transparentes tienden a ser menos precisos, lo que plantea un dilema al intentar explicar decisiones complejas de manera accesible sin sacrificar la exactitud.

Falta de métricas estándar: La ausencia de indicadores comunes para medir la explicabilidad de los modelos dificulta la evaluación uniforme, ya que lo que es comprensible puede variar considerablemente según el perfil de cada usuario.

Transparencia desde el inicio: El futuro de la XAI se orienta hacia integrar la transparencia durante todo el proceso de desarrollo, lo que implica diseñar modelos que consideren desde un principio las demandas de los usuarios.

Adaptación continua: Incorporar una retroalimentación constante a los modelos para ajustar tanto el funcionamiento como las explicaciones ofrecidas, asegurando que se alineen con las necesidades y observaciones de los usuarios.

Enfoque centrado en el usuario: La necesidad de desarrollar sistemas que no solo sean técnicamente sólidos, sino también accesibles y útiles para quienes los utilizan, promoviendo un enfoque centrado en el usuario para mejorar la interacción e interpretación de los resultados proporcionados por la IA.

La inteligencia artificial explicable es un pilar fundamental para edificar un futuro tecnológico más claro y seguro. Conforme la Inteligencia Artificial continúa inmersa en nuestra vida diaria, su habilidad para ser comprendida y valorada éticamente se transforma en una exigencia social. La XAI no solo incrementa la seguridad del usuario, sino que también asegura elecciones más equitativas y basadas en evidencia, abriendo la vía hacia un uso más consciente e inclusivo de la tecnología.